超算级AI芯片的崛起:智能算力需求的爆发式增长

随着人工智能技术的深度渗透,全球算力需求呈现指数级增长。据IDC预测,到2025年全球AI算力规模将突破200EFLOPS,较2020年增长30倍。这种爆发式增长背后,是自动驾驶、大模型训练、科学计算等应用场景对算力的极致要求。传统GPU架构在面对万亿参数级模型时已显疲态,超算级AI芯片的诞生,正重新定义智能算力的边界。

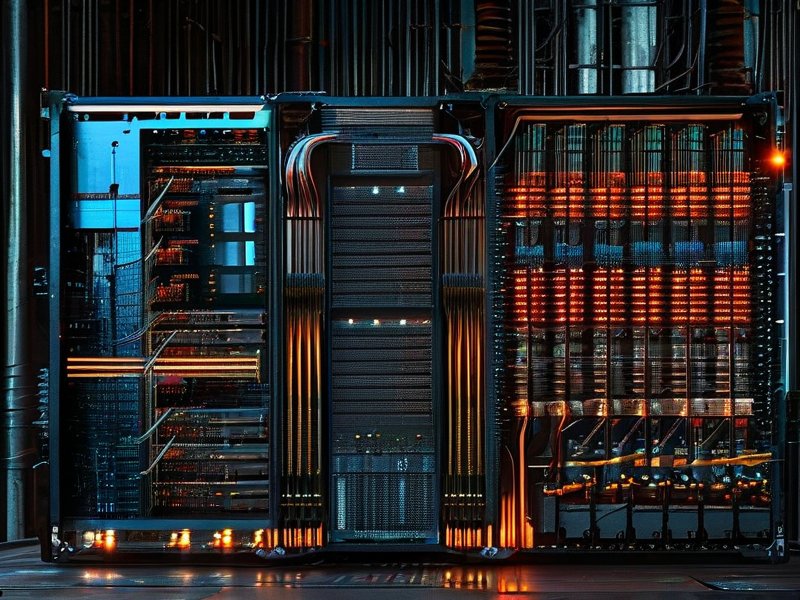

当前AI芯片市场呈现三足鼎立态势:通用GPU、专用AI芯片和ASIC芯片。其中,NVIDIA的Hopper架构芯片凭借其全栈式生态优势,在超算领域持续领跑。其最新旗舰产品NVIDIA H100-SXM(点击查看产品详情)通过架构创新与制程突破,实现了算力密度、能效比和扩展能力的三重跨越,成为下一代智能算力革命的核心引擎。

NVIDIA H100-SXM的技术突破:重新定义超算级AI性能标准

作为Hopper架构的集大成者,H100-SXM芯片在多个维度实现了颠覆性创新:

- 架构层面:采用台积电4nm制程工艺,集成800亿个晶体管,构建了拥有第四代Tensor Core的Transformer引擎,AI训练性能较Ampere架构提升6倍,推理速度提升30倍

- 内存系统:配备40GB HBM3显存,带宽突破3TB/s,结合NVLink高速互联技术,可构建EB级内存池,完美支撑超大规模模型训练

- 安全与扩展:集成Confidential Computing安全模块,支持动态分区技术(NVIDIA Multi-Instance GPU),单卡可虚拟化为7个独立实例,兼顾算力密度与资源隔离需求

在实际应用中,H100-SXM的性能优势尤为显著:

- 在LLM训练场景中,单卡即可承载10万亿参数模型,相比上代产品减少80%的集群规模

- 通过Quantum-2网络结构,节点间通信延迟降低至微秒级,分布式训练效率提升3倍

- 在能效比方面,每瓦特性能突破50TFLOPS,较前代产品降低45%的功耗

这些突破性技术让H100-SXM成为构建exascale级AI超算的基石。在医疗影像分析领域,某顶级医疗机构部署H100集群后,病理图像处理速度提升10倍;在气候模拟场景中,天气预测精度提升至公里级分辨率。随着H100-SXM的规模化部署,智能算力成本有望每年下降40%,加速AI技术在千行百业的渗透。

行业影响:智能算力革命的产业化进程

NVIDIA H100-SXM的推出,正在引发算力产业链的深度变革:

- 云计算服务商加速建设AI超算中心,AWS、Azure等平台已宣布支持H100的实例方案

- 芯片代工环节迎来新机遇,台积电4nm制程产能持续向高性能计算领域倾斜

- 应用开发生态加速繁荣,PyTorch、TensorFlow等框架全面适配Hopper架构新特性

站在智能算力革命的门槛上,H100-SXM不仅是一颗芯片的迭代,更是计算范式升级的里程碑。当万亿参数模型训练时间从数月缩短至数日,当实时推理响应达到毫秒级,我们正在见证AI从实验室走向大规模产业落地的关键转折点。正如NVIDIA创始人黄仁勋所言:"超算级AI芯片将重新定义可能,让每个企业都能获得顶尖的AI算力支持。"