AI算力巨兽觉醒:NVIDIA H200的革命性突破

随着人工智能技术的飞速发展,AI算力需求在过去五年间以年均3.7倍的速度增长。在此背景下,NVIDIA H200 GPU(访问详情:NVIDIA H200)的问世,标志着AI算力领域迎来了一场颠覆性变革。这款采用第四代Tensor Core架构的芯片,凭借其突破性的技术参数,重新定义了高性能计算的边界。

据NVIDIA官方数据显示,H200的FP8计算性能达到惊人的3,700 TFLOPS,是前代产品A100的6倍以上。其创新的HBM3e高带宽内存技术,将内存带宽提升至4TB/s,解决了传统GPU的内存瓶颈问题。更值得关注的是,H200首次在单芯片上集成了AI加速引擎、网络控制器和分布式存储模块,实现了计算、通信与存储的深度融合。

- 能效比突破:相比上一代产品,H200在同等算力下功耗降低40%

- 互联架构革新:NVLink-C2C技术实现900 GB/s的芯片间直连带宽

- 绿色计算:通过动态功耗管理,实现在负载波动时的能效最优

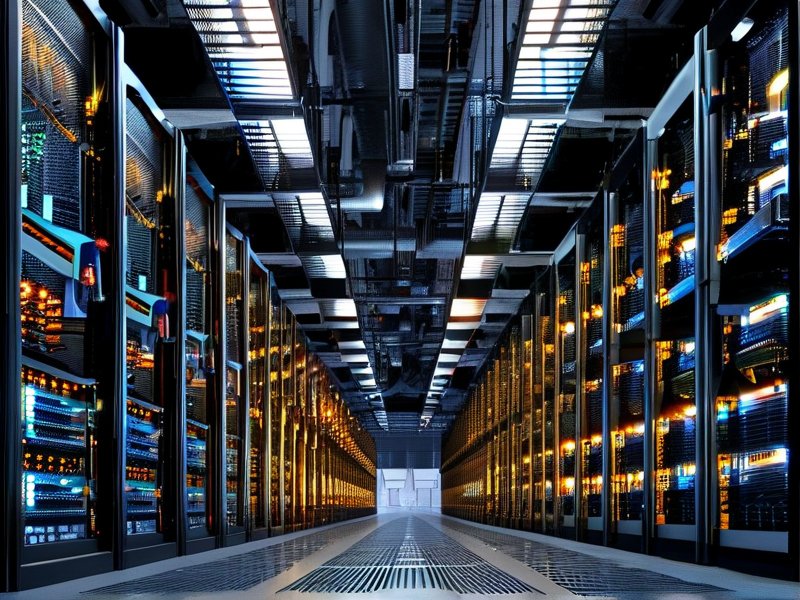

数据中心效能突破极限:全栈优化的智能基础设施

在H200的驱动下,数据中心正经历从硬件到软件的全栈式革新。通过与NVIDIA Quantum-2 InfiniBand网络的协同优化,DGX H100超级计算集群的算力密度达到行业前所未有的水平。数据显示,单个4U机架的AI算力已突破10 PFLOPS,相当于十年前整个国家超算中心的计算能力。

这种效能的飞跃不仅体现在硬件层面。NVIDIA开发的CUDA-X AI软件栈,通过智能任务调度算法,将多GPU集群的利用率从传统模式的65%提升至92%。在实际应用中,某头部云服务商部署H200集群后,其图像识别任务的响应时间缩短了78%,同时能耗成本降低32%。

在行业应用层面,H200的稀疏计算优化技术为大模型训练带来质变。某自动驾驶企业的实测表明,使用H200集群训练BEVFormer模型时,参数效率提升4.2倍,训练周期从72小时缩短至12小时。这种突破正在推动医疗影像分析、气候模拟等领域的技术临界点。

- 液冷方案:配合冷板式液冷系统,实现PUE(电源使用效率)低于1.1

- 智能运维:通过AI驱动的预测性维护,故障率降低85%

- 云边协同:支持分布式训练架构,算力可灵活调配至边缘节点

随着H200的规模化部署,全球数据中心的AI算力总规模预计将在2026年达到40 EFLOPS,这不仅将重塑云计算、自动驾驶等现有产业,更将催生智能机器人、元宇宙等新兴领域的爆发式增长。这场由NVIDIA H200引发的算力革命,正在将人类社会推向真正的智能时代。