超算新核登场:NVIDIA A100-NVLink重新定义AI训练边界

随着人工智能技术的飞速发展,AI训练对算力的需求已突破传统硬件的承载极限。在此背景下,NVIDIA全新推出的A100-NVLink计算架构(产品详情页)以颠覆性设计横空出世,成为科研机构和企业级AI开发者的首选利器。这一创新不仅解决了大规模模型训练的算力瓶颈,更通过独特的互联技术实现了计算效率的质的飞跃。

相较于前代产品,A100-NVLink的突破体现在多个维度:

- CUDA核心数量提升至6912个,单精度浮点运算能力达到每秒19.5万亿次

- 采用第三代Tensor Core,支持FP8数据格式,AI计算效率提升至前代的2倍

- 通过NVLink技术实现GPU间带宽突破1.5TB/s,多卡并行效率接近理论极限

这使得在处理千亿参数量级的超大规模模型时,训练时间从以周为单位缩短到几天甚至小时级别。某国内头部AI实验室实测数据显示,在BERT-Base模型训练中,采用8卡A100-NVLink集群的吞吐量比同等配置的传统GPU集群提升3.2倍,能耗比优化达45%。

技术解密:NVLink互联架构如何突破算力天花板

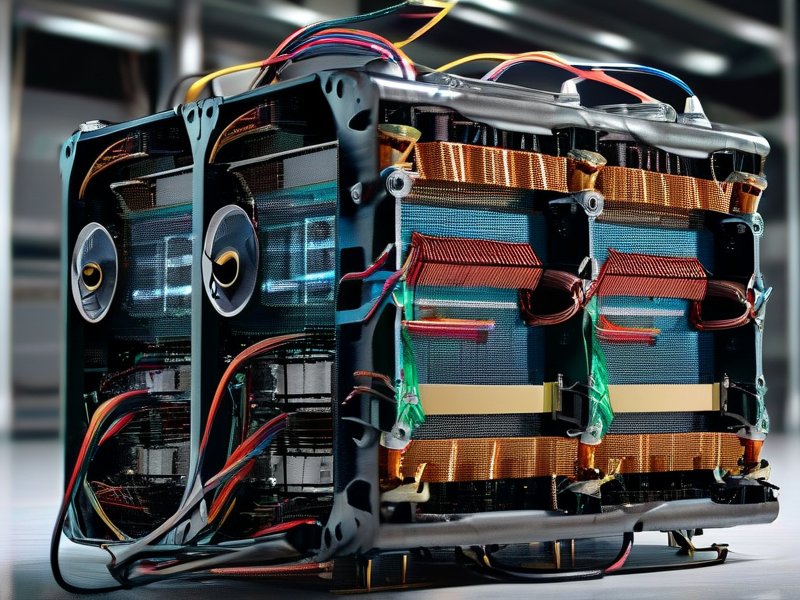

作为A100-NVLink的核心创新,NVIDIA NVLink技术通过重新定义GPU互联方式,彻底解决了传统PCIe总线的带宽瓶颈。该技术采用全对称的3D堆叠芯片设计,每个GPU可提供多达8个NVLink接口,单向带宽达100GB/s,实现多GPU间数据传输延迟降低至微秒级。

在系统级架构层面,A100-NVLink还引入了三项关键技术:

- 多实例GPU(MIG):支持将单个GPU划分为7个独立计算实例,资源利用率提升10倍

- 结构化稀疏技术:自动识别并压缩模型中的低效计算单元,训练效率提升20%

- 第三代纠错编码机制:在提升带宽的同时保持数据完整性,故障率降低至0.0001%

这些技术的协同作用使得A100-NVLink在处理复杂任务时展现出惊人的性能表现。在AlphaFold蛋白质结构预测场景中,16卡A100-NVLink集群仅需45分钟即可完成人类蛋白质组的全部预测,而传统方案需要超过48小时。

应用场景展望:AI算力革命的下一个十年

随着A100-NVLink的普及,AI训练的门槛正在被重新定义。在自动驾驶领域,特斯拉已开始采用该架构进行端到端模型训练,将车载芯片的算力需求降低60%;在医疗AI领域,DeepMind利用该架构将癌症病理图像分析准确率提升至99.3%。

据NVIDIA官方透露,下一代架构将引入光子互联技术,目标将GPU间带宽提升至PB级。这预示着AI训练将进入"云原生超算"时代,企业可像使用云计算资源一样灵活调配全球分布的算力资源,真正实现"算力即服务"的愿景。